Ada yang pernah tau tragedi pelemparan pie (pieing) kepada Bill Gates di Brussels pada tahun 1998? Hmm..kita tidak akan membahas tentang kejadian ini, tetapi kita yang akan kita bahas kali ini adalah machine translation dengan menggunakan attention!

Mari belajar beberapa bahasa terlebih dahulu:

ID: Dia (laki-laki) melempar saya dengan sebuah pie.

ENG: He hit me with a pie.

FR: il a m’ entarté

Kita akan mengambil Bahasa Inggris dan Perancis untuk contoh dalam Machine Translation yang akan kita bahas kali ini.

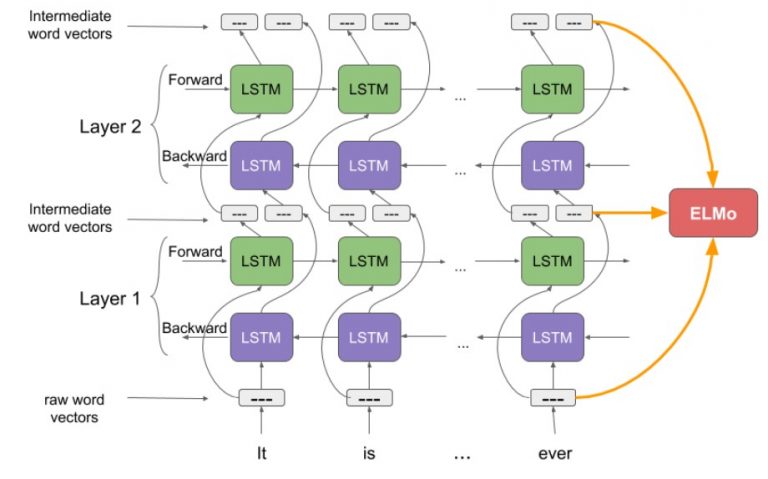

Arsitektur Encoder Decoder paling sering digunakan pada Neural Machine Translation, tetapi tahukah kamu, bahwa ada problem yang menyebabkan Encoder Decoder tidak memberikan performance yang optimal. Lihat Gambar disamping berikut ini. Ketika menggunakan arsitektur encoder-decoder atau seq2seq terjadi information bottleneck problem. Karena RNN cell pada step terakhir encoder harus mengcapture semua informasi dari source sentence untuk kemudian diinputkan ke decoder. Ini tentu saja tidak efektif, karena informasi pada step-step awal bisa saja hilang, padahal mungkin kata-kata tersebut yang akan memberikan informasi lebih banyak dalam proses translasi di kata-kata tertentu pada bagian decoder. (source gambar: http://web.stanford.edu/class/cs224n/slides/cs224n-2021-lecture07-nmt.pdf)

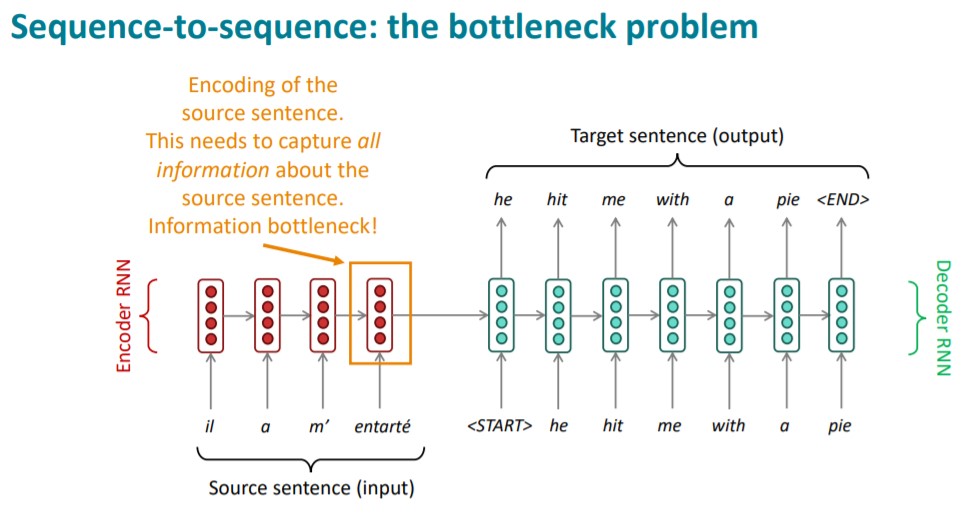

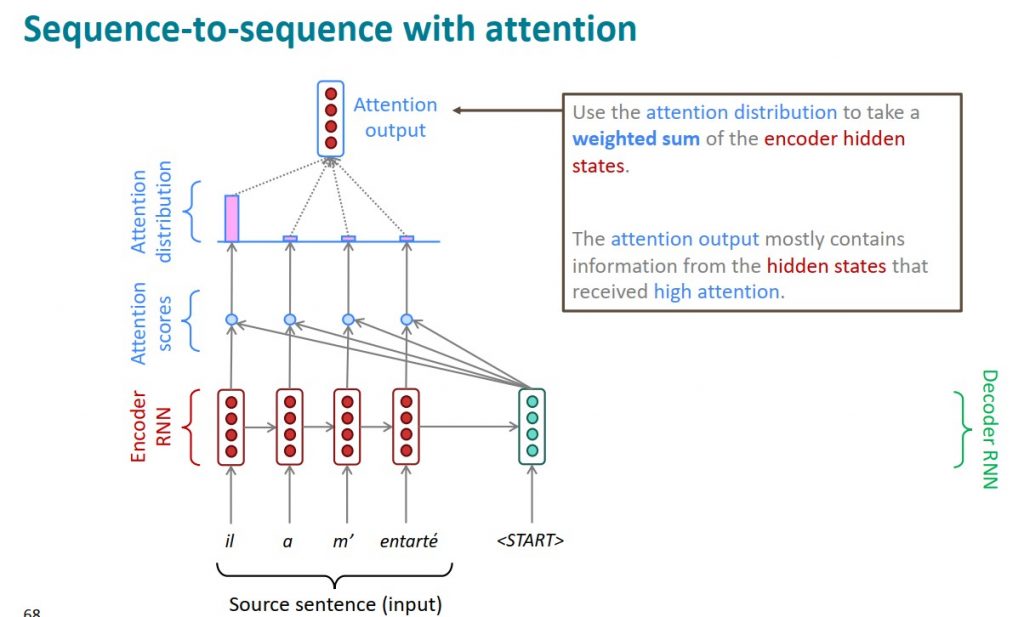

Lalu bagaimana attention bisa menyelesaikan masalah ini? Dengan mekanisme attention, akan dihitung attention score untuk masing-masing kata pada encoder. Dari score ini, kemudian diubah menjadi attention distribution yang menunjukkan seberapa besar pengaruh dari sebuah kata pada encoder/source sentence terhadap kata yang akan dihasilkan pada sebuah step di decoder. Dengan cara ini, information bottleneck problem yang dihadapi pada seq2seq bisa diselesaikan, sekaligus bisa mengimprove performance dari machine translation itu sendiri. Ilustrasi dari attention bisa dilihat pada gambar berikut (source gambar: http://web.stanford.edu/class/cs224n/slides/cs224n-2021-lecture07-nmt.pdf)

Untuk lebih lengkapnya, teman-teman bisa menyimak kuliah mengenai NMT dari Stanford University berikut ini https://youtu.be/XXtpJxZBa2c